Para quem não sabe, deepfake é uma tecnologia capaz de criar vídeos falsos, mas muito realistas, de pessoas fazendo coisas que elas nunca fizeram na vida real através de uma inteligência virtual. Essa tecnologia já foi usada várias vezes e já gerou desde conteúdos pornográficos com celebridades, até discursos fictícios de políticos influentes.

Justamente por conta do “realismo” que o deepfake pode passar hoje em dia que o YouTube não irá mais permitir um conteúdo que “simula de forma realista” narração de menores de idade ou outras vítimas de crimes a respeito de como elas morreram ou da violência que sofreram. Essa mudança é parte da atualização das políticas da plataforma com relação ao assédio e ao cyberbullying.

O foco dessa atualização parece ser em um subgênero de conteúdos relacionados ao true crime, ou seja, crimes reais. Em vídeos desse tipo, às vezes, deepfakes eram usados para os relatos das vítimas a respeito do que elas passaram. Em alguns vídeos existem vozes geradas por inteligência artificial parecida com a de crianças.

Penalidades

Olhar digital

Com a atualização, o usuário que usar o deepfake terá o conteúdo removido do seu canal e o que ele poderá fazer na plataforma também será limitado por um tempo. Por exemplo, um primeiro aviso limita ele de postar vídeos por uma semana.

Se o usuário voltar a violar a política em 90 dias, suas penalidades irão aumentar podendo ter o seu canal deletado pelo YouTube.

Deepfake

MarketWatch

Essa política e preocupação do YouTube com o deepfake não é uma coisa nova ou exclusiva. Tanto que, em novembro do ano passado, o governo da Índia fez um alerta para o Facebook e para o YouTube a respeito das regras do país contra publicações de conteúdo deepfake.

De acordo com a Reuters, outras empresas de mídias sociais também receberam uma notificação e foram lembradas de que o país tem normas contra a técnica como com relação à desinformação.

Quem fez esse alerta foi o vice-ministro de TI, Rajeev Chandrasekhar, em uma reunião a portas fechadas. Na ocasião, o ministro ressaltou que várias empresas não atualizaram seus termos de uso, mesmo essas regras estando em vigor desde 2022.

Outro ponto pedido por Chandrasekhar foi que as empresas aumentassem a conscientização a respeito das regras, e lembrassem os usuários, sempre que eles fizessem login, que não podem postar conteúdos deepfake.

Conforme o próprio ministro, esse alerta é uma exigência “inegociável” do governo indiano. Ainda segundo ele, se as empresas não seguirem essas regras e colocarem reforços em seus filtros, medidas mais restritivas serão colocadas e provavelmente penalidades maiores serão postas em prática.

Esse alerta sobre deepfake veio logo depois que o ministro de tecnologia da informação do país, Aswini Vaishnaw, anunciar que a Índia está elaborando novas medidas para detectar e limitar a disseminação de deepfakes e mais conteúdos que sejam prejudiciais e que são produzidos com inteligência artificial.

A criação de um regulamentação a respeito dos conteúdos criados por inteligência artificial veio depois de reuniões com representante de grandes empresas de mídia social, a Associação Nacional de Empresas de Software e Serviços (NASCOMM), e acadêmicos do tema.

Uso

BBC

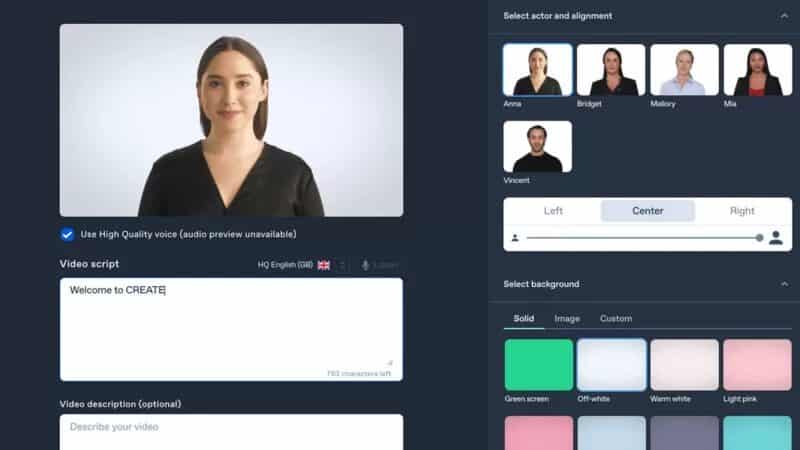

Embora haja muita gente que use o deepfake para fins, digamos, menos nobres, há também experimentos bem interessantes. Uma das primeiras empresas a usar a tecnologia do deepfake foi a Synthesia, companhia com sede em Londres que cria vídeos de treinamento corporativo. “Este é o futuro da criação de conteúdo”, disse o executivo-chefe e cofundador da Synthesia, Victor Riparbelli.

“Para fazer um vídeo gerado por inteligência artificial usando o sistema da Synthesia, você simplesmente escolhe entre vários avatares, digita a palavra que deseja que eles digam e pronto”, explicou.

Nesse ponto, Riparbelli diz que isso significa que as empresas podem, facilmente, fazer vídeos em diferentes idiomas para que sejam usados em cursos de treinamento.

“Digamos que você tenha três mil trabalhadores de armazém na América do Norte. Alguns falam inglês, mas alguns podem estar mais familiarizados com o espanhol. Se você precisa comunicar informações complexas a eles, um PDF de quatro páginas não é uma boa maneira. Seria muito melhor fazer um vídeo de dois ou três minutos, em inglês e espanhol. Se você tivesse que gravar cada um destes vídeos, seria um trabalho enorme. Agora podemos fazer isso com um pequeno custo de produção e o tempo que alguém levar para escrever o roteiro. Isso exemplifica muito bem como a tecnologia é usada hoje”, ressaltou.

Com isso, o uso da tecnologia deepfake está “crescendo significativamente ano após ano, mas os números exatos são difíceis de cravar”, como disse Mike Price, diretor de tecnologia da ZeroFox, empresa de segurança cibernética dos EUA que rastreia deepfakes.

“O termo deepfake definitivamente teve uma resposta negativa em termos de investimento de capital no setor. A mídia e os consumidores, com razão, podem ver claramente os riscos associados. Isso definitivamente impediu as corporações e os investidores de investir na tecnologia. Mas acho que se começa a ver essa abertura”, pontuou ele.

“Não devemos ter muito medo da tecnologia, e é preciso haver abordagens diferenciadas para isso. Sim, deve haver leis para reprimir coisas nocivas e perigosas, como discurso de ódio e pornografia de vingança. Os indivíduos e a sociedade devem ser protegidos disso. Mas não devemos ter uma proibição total dos deepfakes por sátira ou liberdade de expressão. E o crescente uso comercial da tecnologia é muito promissor, como passar filmes para diferentes idiomas ou criar vídeos educativos envolventes”, concluiu a professora Sandra Wachter, pesquisadora de inteligência artificial da Universidade de Oxford, no Reino Unido.

Fonte: Olhar digital

Imagens: Olhar digital, MarketWatch, BBC

Comentários